在使用Gurobi求解大规模优化问题时,内存使用情况往往成为影响效率甚至能否求解成功的关键因素之一。特别是在处理包含成千上万个变量与约束的模型时,内存资源一旦不足,就会导致程序中断、求解失败甚至系统宕机。因此,“Gurobi内存不足怎么扩Gurobi如何设置内存限制”这两个问题备受关注。本文将从Gurobi的内存管理机制出发,详细讲解如何扩充或释放内存资源,并介绍实际可操作的内存设置参数,助你顺利完成大型优化建模任务。

一、Gurobi内存不足怎么扩

Gurobi对内存的需求取决于模型的规模、变量类型、求解策略等多个因素。若模型在求解过程中出现“out of memory”(内存溢出)错误,可以从以下几个方向着手扩展内存的使用空间。

1.增加操作系统的物理内存

这是最直接也最有效的方式。如果你经常运行超大规模模型,建议:

将内存扩展至16GB、32GB或更高;

在服务器环境下,可配备64GB、128GB+RAM以应对企业级问题;

使用ECC内存提高计算稳定性,避免硬件层级的崩溃。

2.利用Gurobi的节点文件缓存机制(Nodefile)

对于MIP求解中节点数极多导致内存爆炸的情况,Gurobi提供了将中间节点写入磁盘缓存的机制,有效减少物理内存压力。

关键参数:NodefileStart

model.setParam("NodefileStart",0.5)#超过0.5GB内存后启用磁盘缓存

含义是当Gurobi内存使用超过0.5GB时,自动将分支节点写入磁盘文件(而不是保存在内存中)。

存储路径可通过TempDir设置:

、

model.setParam("TempDir","/path/to/fast/disk/")

建议配置到SSD分区或专用IO优化目录,避免硬盘性能成为新瓶颈。

3.优化建模结构,减少内存占用

减少冗余变量和约束;

使用稀疏矩阵构造方式;

避免构造复杂表达式链,尤其是大量变量相乘;

利用Gurobi的update()和remove()方法及时清理不再使用的变量和约束。

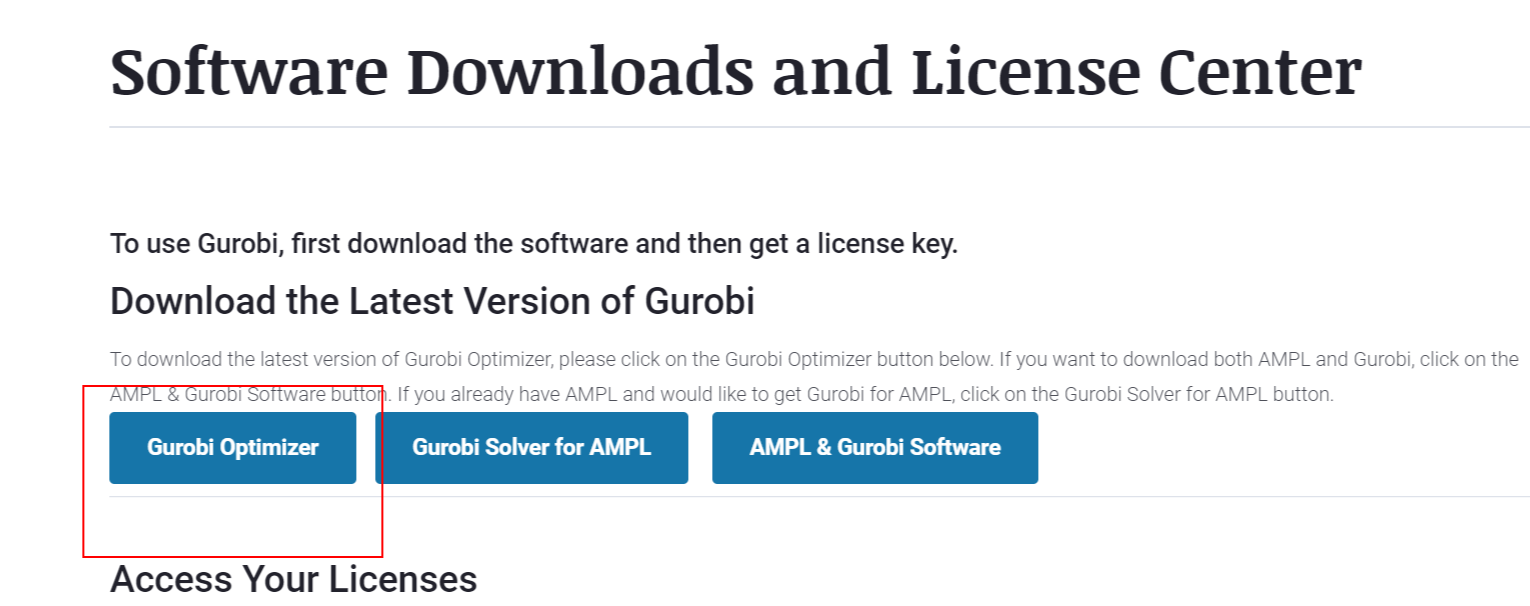

4.使用64位操作系统+64位Gurobi版本

确保使用64位系统环境,这是访问大内存的前提条件。Gurobi官方建议在Windows、Linux、macOS上均安装并使用64位版本,以突破32位系统4GB内存限制。

5.多阶段建模与求解

若模型过于庞大,可分阶段建模:

阶段一:使用简化模型获取近似可行解;

阶段二:在结果基础上重建精细模型局部优化。

这种方式有效降低一次性建模的内存峰值。

6.启用模型压缩保存方式

在写入.mps或.lp模型文件时,使用压缩格式可避免内存使用过大:

model.write("model.mps.bz2")#自动压缩

方便后续恢复或传输时减少空间消耗。

二、Gurobi如何设置内存限制

虽然大多数情况下我们希望“用更多内存提升求解性能”,但在资源受限(如嵌入式系统、多人共享服务器等)场景中,也常常需要控制Gurobi的最大内存使用量。下面是几个关键参数和技巧。

1.控制节点缓存大小(NodefileStart)

如上所述,此参数可有效限制“使用内存”的峰值,防止MIP求解阶段节点数量失控。

model.setParam("NodefileStart",1.0)#限制最大占用内存为1GB

超出后自动转存到磁盘文件,以节省内存,但需权衡IO速度。

2.设置Threads参数,间接控制内存占用

多线程求解会并发使用多个核心,每个线程也会占用一部分内存。

model.setParam("Threads",2)#限制最多使用2个线程

适用于低内存服务器,减少并发带来的内存开销。

3.启用ConcurrentMIP=0,避免并发策略求解

默认情况下,Gurobi可能会启用多个策略并发测试,某些策略分支会并行消耗更多内存,关闭可节约资源:

model.setParam("ConcurrentMIP",0)

4.限制WorkLimit(高级设置)

Gurobi还提供WorkLimit参数来限制总资源消耗,但该参数较为少见,仅适用于企业高级版本:

model.setParam("WorkLimit",1e9)#限制为10亿单位工作量

注意这是一个抽象的工作计量单位,并非实际MB/G内存。

5.观察和评估内存占用

通过日志可以查看内存使用情况:

建议在求解过程中持续监测Nodefile size和Memory usage变化趋势,及时进行策略调整。

6.关闭不必要的日志输出避免缓冲占用

长时间运行任务如不设置日志上限,容易造成内存缓冲堆积。可通过以下方式控制:

model.setParam("LogFile","")#不保存日志文件

model.setParam("OutputFlag",0)#屏蔽控制台日志

可用于后台任务或批处理场景,减轻日志带来的资源负担。

三、内存与求解效率的平衡建议

扩展内存能提升求解能力,但也要注意“不是越多越好”。以下是一些实际工作中的权衡建议:

对LP/QP模型:内存影响不大,优化目标是提升算法精度与稳定性;

对MIP模型:建议使用Nodefile+warm-start技术,将主内存压力转为磁盘IO;

模型调试期:增加日志与变量打印可能导致内存暴涨,建议开启时限或调试版本;

多用户环境:限制每个模型线程数与缓存量,避免模型间互抢内存资源。

如有更复杂的调度优化任务,建议将模型分解为多个子模型,分批执行,并使用结构共享或参数传递机制减少重复加载数据带来的资源浪费。

四、总结

综上所述,围绕“Gurobi内存不足怎么扩Gurobi如何设置内存限制”两个问题,本文系统介绍了从硬件扩容、Gurobi参数设置、建模优化、缓存机制等多个层面实现内存资源的合理配置。对于大规模建模任务,既要学会“提升内存利用能力”,也要掌握“限制资源消耗的边界”,这样才能在不同计算环境下做到稳健、快速地完成求解目标。